DeepSeek本地化部署与ChatBox交互设置教程(集成显卡与移动设备均可)

背景导读

DeepSeek是由深度求索公司开发的一款强大的智能助手模型。它能够帮助用户高效地回答问题、提供信息,并执行多种任务。然而,为了更好地控制数据隐私和优化性能,许多用户选择将该模型进行本地化部署,而不是依赖于云服务。

本地化部署意味着你在自己的服务器或计算环境中安装和运行DeepSeek模型。这样做的好处包括更高的数据隐私性、更低的延迟以及更灵活的资源管理。此外,通过配置ChatBox进行交互设置,用户可以更直观地与模型进行互动,测试其性能,并根据需求进行调优。

本教程将指导你完成DeepSeek的本地化部署以及ChatBox交互设置的全过程,确保你能够顺利地在本地环境中运行并使用DeepSeek模型,同时在第三节我们也带来了全平台调用第三方云API部署满血版本DesspSeek教程。

一、安装准备 下载并安装必备程序

链接: https://pan.baidu.com/s/11hwJSnZaGc5Eyg04lfT3qw 提取码: r7vg

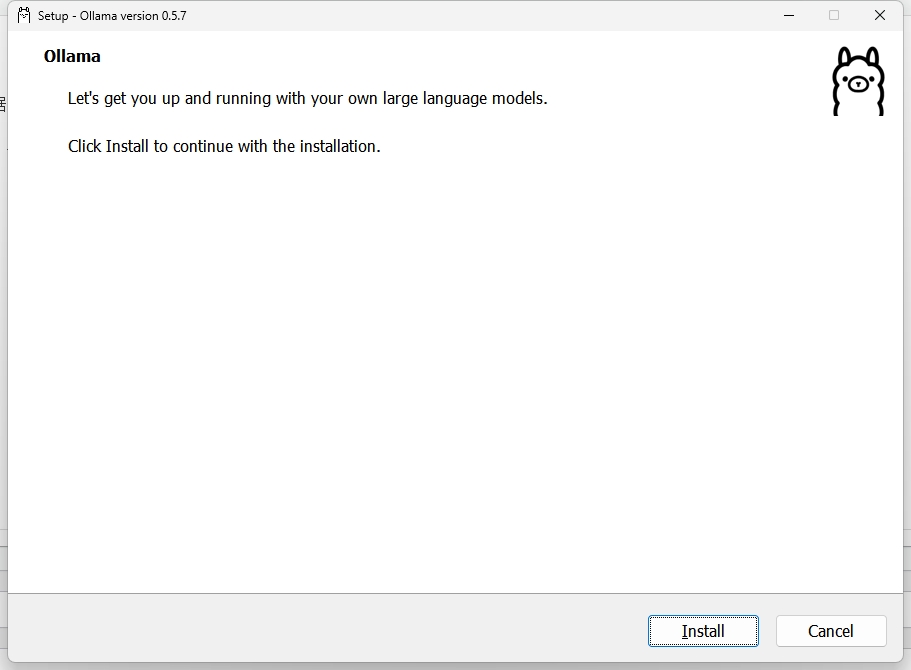

1.双击打开windows-OllamaSetup.exe 安装 Ollama (Install 后一直继续即可)

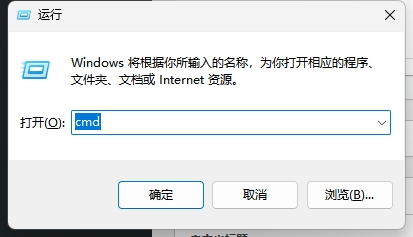

2.按下 Win+R 打开对话框 输入 CMD 确定 然后 输入对应命令安装Deepseek对应模型

1.模型安装说明:

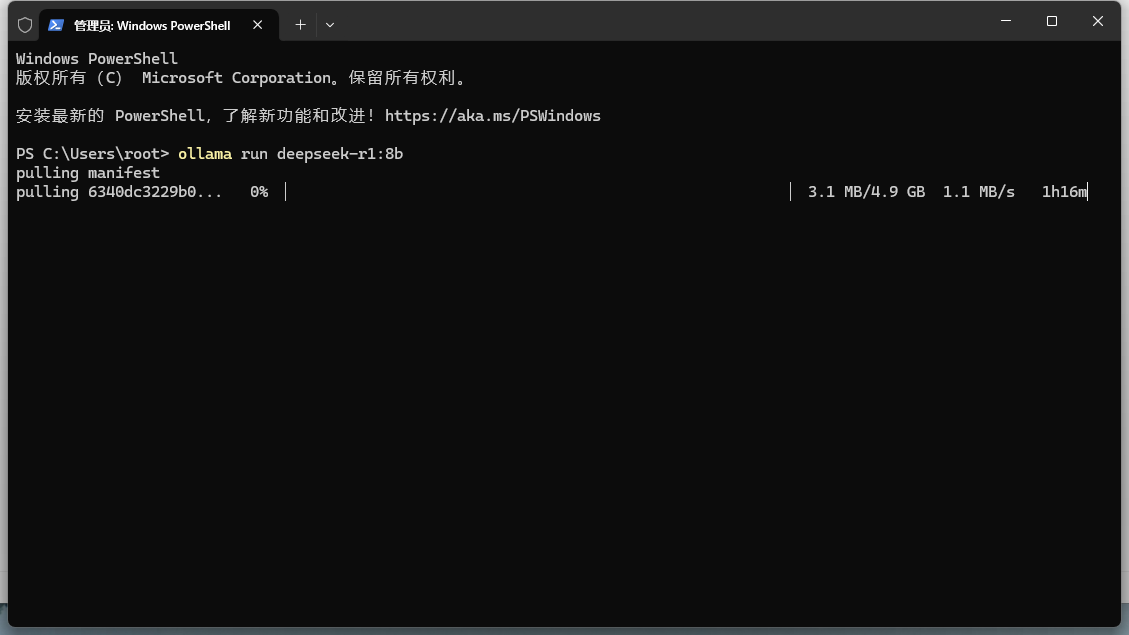

# 没有GPU:1.5B Q8推理 或者 8B Q4推理 # 4G GPU:8B Q4推理 # 8G GPU:32B Q4推理 或者 8B Q4推理 # 16G GPU:32B Q4推理 或者 32B Q8推理 # 24G GPU: 32B Q8推理 或者 70B Q2推理 # 1.5B Qwen DeepSeek R1 安装命令 ollama run deepseek-r1:1.5b # 7B Qwen DeepSeek R1 安装命令 ollama run deepseek-r1:7b # 8B Llama DeepSeek R1 安装命令 ollama run deepseek-r1:8b # 14B Qwen DeepSeek R1安装命令 ollama run deepseek-r1:14b # 32B Qwen DeepSeek R1 安装命令 ollama run deepseek-r1:32b # 70B Llama DeepSeek R1 安装命令 ollama run deepseek-r1:70b

2.我们以8B为例,等待进度条跑满后即可体验:

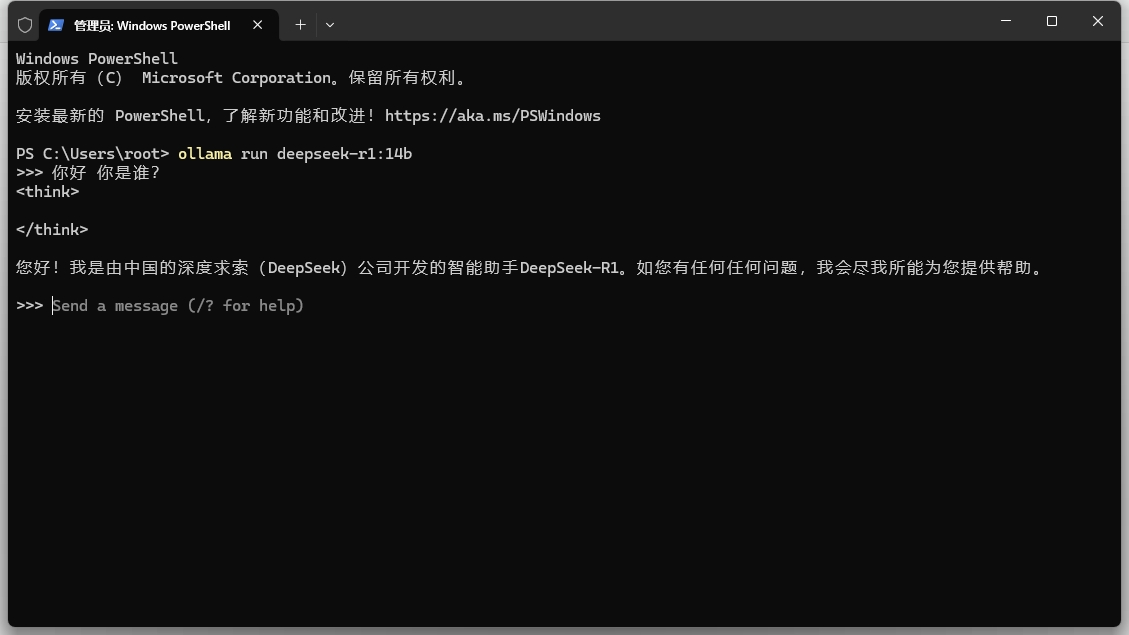

3.安装完成 命令行输入对应模型指令启动对话

二、安装ChatBox 并与本地DeepSeek完成配置交互

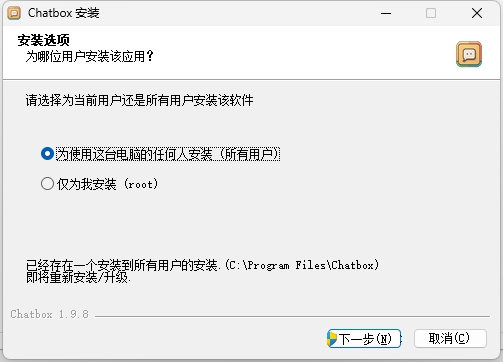

1.双击打开 Chatbox-1.9.8-Setup.exe 完成ChaBox安装(一直下一步即可)

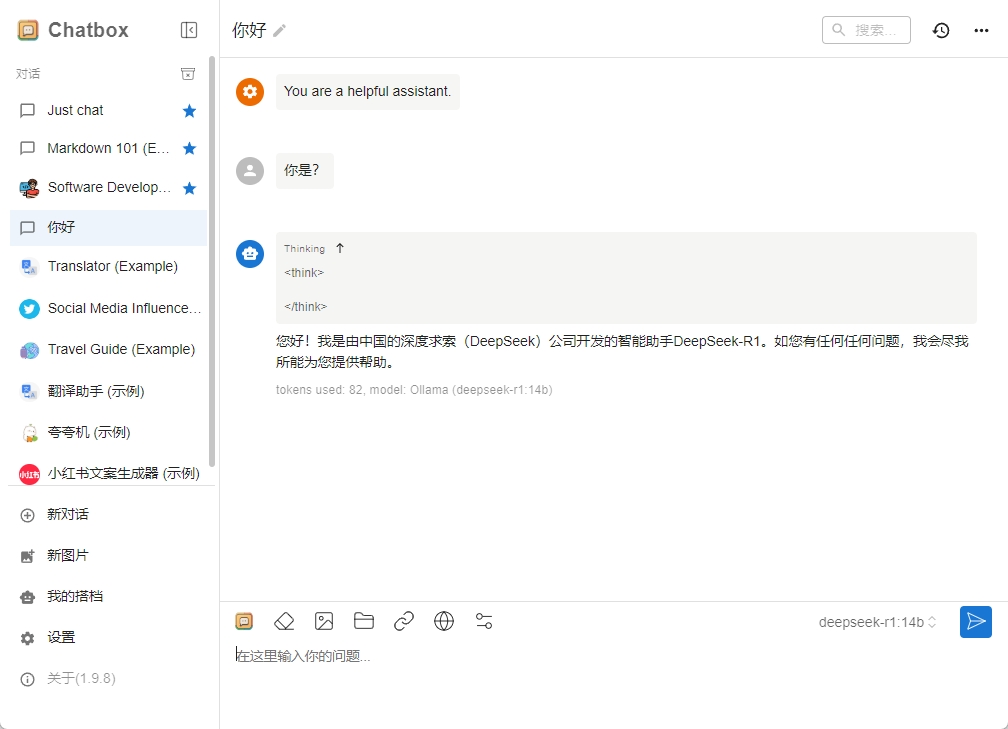

2.配置ChatBox与DeepSeek完成交互 选择模型提供方 OLLAMA API 后并设置对应模型版本后保存 即可

3.配置完成 开始体验 (第一次对话会有点慢 具体加载时间取决于电脑配置)

三、调用第三方API完成部署(低配及移动端、还有想体验满血DeepSeek的看过来)

1.我们以 硅基流动 为例 使用本文章链接注册后完成实名认证赠送14元可体验满血版本

注册链接:https://cloud.siliconflow.cn/i/ukdh8NYO

2.创建API密钥(创建后点击 眼睛 图标复制密钥)

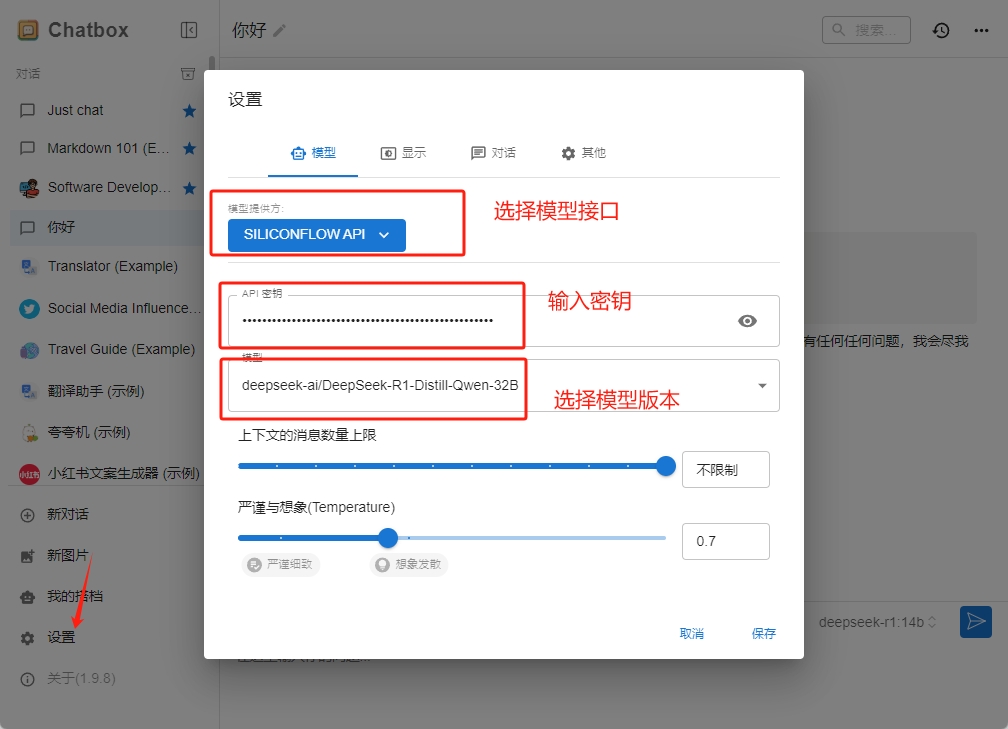

3.设置ChatBox 完成交互配置 选择 SILICONFLOW API 后输入密钥 选择想用的版本即可

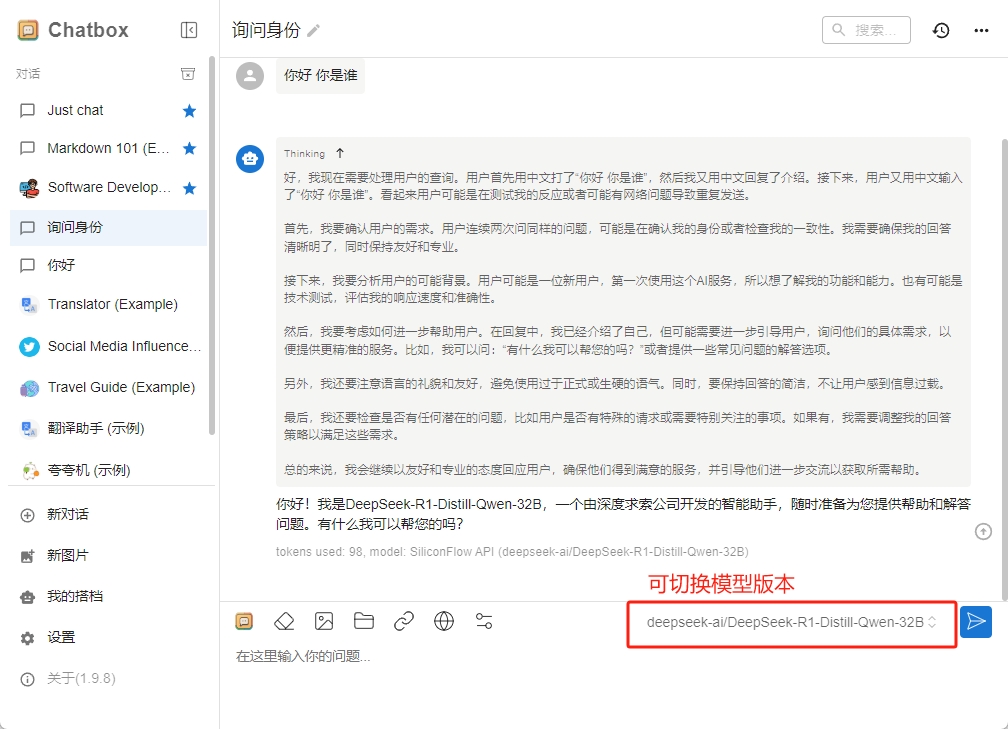

4.完成配置并开始体验

5.移动端配置(因为操作类似就不具体演示了)

ChatBox移动版本下载地址: https://chatboxai.app/zh

好了,现在就让AI提高你的生产效率吧~

深度体验了一段时间,总的来说不能取代我的工作但是绝对是一个很好的帮手,在任何时间他可以帮你开拓思维打开眼界,以不同的思维方式或者视角不带主观意识的去帮你思考或者看待一些问题

我想这也是时间的朋友里面跨年罗胖所讲到的“AI蓝军”,或许他们目前不能帮你取代工作,但是你可以以低投入去提前组建自己的“AI蓝军”通过自身工作经验的总结让AI也能完成你能处理的工作成为你工作中的一环甚至你的小助手。

本文系作者 @Miko 原创发布在 ITzo - 记录点滴,乐在分享。未经许可,禁止转载。